第一章

pyspark基本的使用教程

并进行简单的数据分析

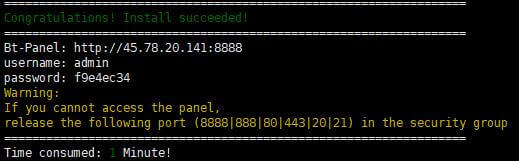

from pyspark import SparkContext, SparkConf

#创建spark

conf = SparkConf().setMaster('local').setAppName('MyApp')

sc = SparkContext(conf=conf)

#读取本地文件

pair_object = sc.textFile('./log.txt')

#pyspark生成的rdd保存到内存中

pair_object.cache()

#按行分割,然后取第二列,并转化成元组

pair_add1 = pair_object.map(lambda line: (line.split("\t")[2],1))

#通过元组进行汇总

pair_add2 = pair_add1.reduceByKey(lambda x1,x2:x1+x2)

#进行排序,ascending为Flask是降序,否则为升序

pair_add2 = pair_add2.sortBy(lambda tp: tp[1], ascending=False)

#将rdd转化成python可识别的元组并进行输出

print(pair_add2.collect())

print(len(pair_add2.collect()))

#关闭pyspark

sc.stop()此分享结束!

© 版权声明

THE END

![表情[tuosai]-阳光明媚](https://www.cnzxv.cn/wp-content/themes/zibll/img/smilies/tuosai.gif)

![表情[xiaojiujie]-阳光明媚](https://www.cnzxv.cn/wp-content/themes/zibll/img/smilies/xiaojiujie.gif)

暂无评论内容